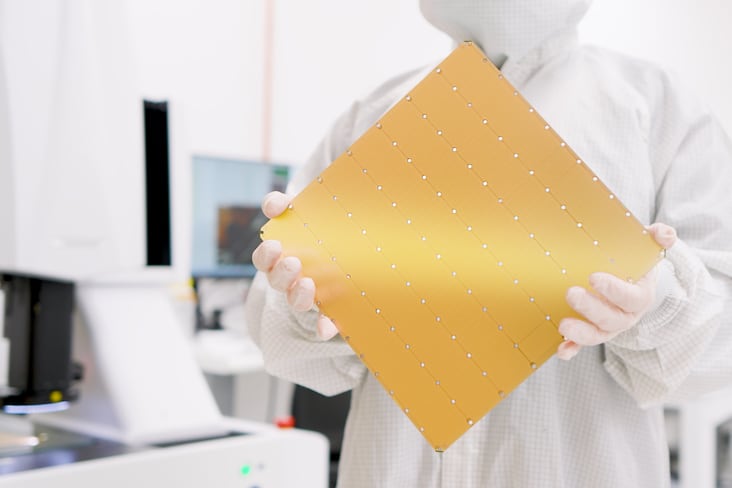

La pépite de Sunnyvale vient de dévoiler "la puce d'IA la plus rapide au monde" dotée de 4000 milliards de transistors, doublant au passage son record mondial. Ce tour de passe-passe est notamment rendu possible grâce à l'introduction du Wafer Scale Engine 3 (WSE-3). Cette puce offre des performances deux fois supérieures à celles de la précédente version, WSE-2, pour la même consommation d'énergie et le même prix.

Conçue pour l'entraînement des plus grands modèles d'IA de l'industrie, WSE-3 est basée sur la technologie 5 nanomètres signée TSMC et dotée de 4000 milliards de transistors afin d'équiper le dernier système d'IA Cerebras CS-3. A la clé : 125 pétaflops (soit 125 millions de milliards d'opérations en une seconde) de performances IA maximales grâce à ses 900 000 cœurs de calcul optimisés pour l'IA.

Un coup d'accélérateur pour l'entraînement de grands modèles de langage

Le système CS-3 est conçu pour entraîner des modèles de langage 10 fois plus grands que GPT-4 et Gemini, pour ne citer qu'eux. Il s'appuie pour cela sur un important système de mémoire pouvant atteindre 1,2 pétaoctet. Par ailleurs, 24 000 milliards de modèles de paramètres peuvent être stockés dans un seul espace mémoire logique sans partitionnement ni remaniement, assure Cerebras. Un avantage considérable en matière de simplification du workflow d'entraînement et pour la productivité des développeurs.

"L'apprentissage d'un modèle à mille milliards de paramètres sur le CS-3 est aussi simple que l'apprentissage d'un modèle à un milliard de paramètres sur les GPU", assure l'entreprise. Les configurations compactes à quatre systèmes permettent d'affiner des modèles de type 70B en une journée, tandis qu'à grande échelle, en utilisant 2048 systèmes, Llama 70B peut, par exemple, être entraîné à partir de rien en une seule journée.

Parmi ses autres points forts, le CS-3 offre une facilité d'utilisation supérieure, nécessitant 97% de code en moins que les GPU pour les LLM et la capacité d'entraîner des modèles allant de 1B à 24T paramètres. Par exemple, une implémentation standard d'un modèle de taille GPT-3 n'a nécessité que 565 lignes de code sur Cerebras, ce que l'entreprise considère être "un record dans l'industrie".

Près de dix ans de développement et un portefeuille clients bien rempli

La société américaine Cerebras a été fondée en 2015 par Andrew Feldman (actuel CEO), Gary Lauterbach, Michael James, Sean Lie et Jean-Philippe Fricker avec pour objectif de construire des systèmes informatiques pour des applications complexes d'IA. Elle possède aujourd'hui des bureaux à Sunnyvale et San Diego, Toronto, Tokyo et Bangalore, en Inde.

Son carnet de commandes s'est rapidement rempli pour CS-3, indique-t-elle, notamment auprès d'entreprises, de gouvernements et de fournisseurs de cloud mondiaux. Les puces de Cerebras sont d'ores et déjà utilisées dans les secteurs de l'énergie, de la santé et du cloud, dans l'industrie pharmaceutique (AstraZeneca, GlaxoSmithKline), par la défense et les laboratoires utilisant des supercalculateurs, notamment l’Argonne National Laboratory à Chicago, qui abrite le premier supercalculateur exaflopique américain.

Cerebras va alimenter le prochain supercalculateur de G42

Dans la foulée, Cerebras a fait part d'une annonce concernant son partenariat avec G42, une entreprise basée à Abu Dhabi qui projette de construire et d’entraîner un concurrent arabe au robot conversationnel d’OpenAI ChatGPT. Par le passé, le partenariat entre Cerebras et G42 a déjà fourni 8 exaFLOPs de performance de supercalculateur d'IA via Condor Galaxy 1 (CG-1) et Condor Galaxy 2 (CG-2), deux supercalculateurs déjà déployés en Californie et comptant parmi les plus grands supercalculateurs d'IA au monde.

Aujourd'hui, les deux entreprises ont annoncé que Condor Galaxy 3 était en cours de construction. Ce supercalculateur sera construit avec 64 systèmes CS-3, produisant 8 exaflops de performances pour les calculs liées à l'IA. Par comparaison, le supercalculateur Eos dévoilé par Nvidia début janvier est capable de fournir un total de 18,4 exaflops de performances FP8 pour les calculs liés à l'IA. A terme, "le partenariat stratégique entre Cerebras et G42 devrait permettre de produire des dizaines d'exaflops de calcul d'IA", estime la société californienne.

![[ÉNERGIES] Déployez vos projets IA à l’échelle, inspirez-vous du cas ENGIE Entreprises et Collectivités](https://cdn.webikeo.com/webinar_logo/2025-10-24-ac93013fcd6c2ea907b5a091f0e74c90.png)